Для того, чтобы разрешить или же запретить индексацию отдельных страниц или записей сайта в поисковые системы (например, Яндекс, Rambler, Bing, Google, Yahoo...), используется файл robots.txt. Он есть на каждом сайте, и располагаеся в корневой директории Вашего сайта. Но что такое индексация страниц?

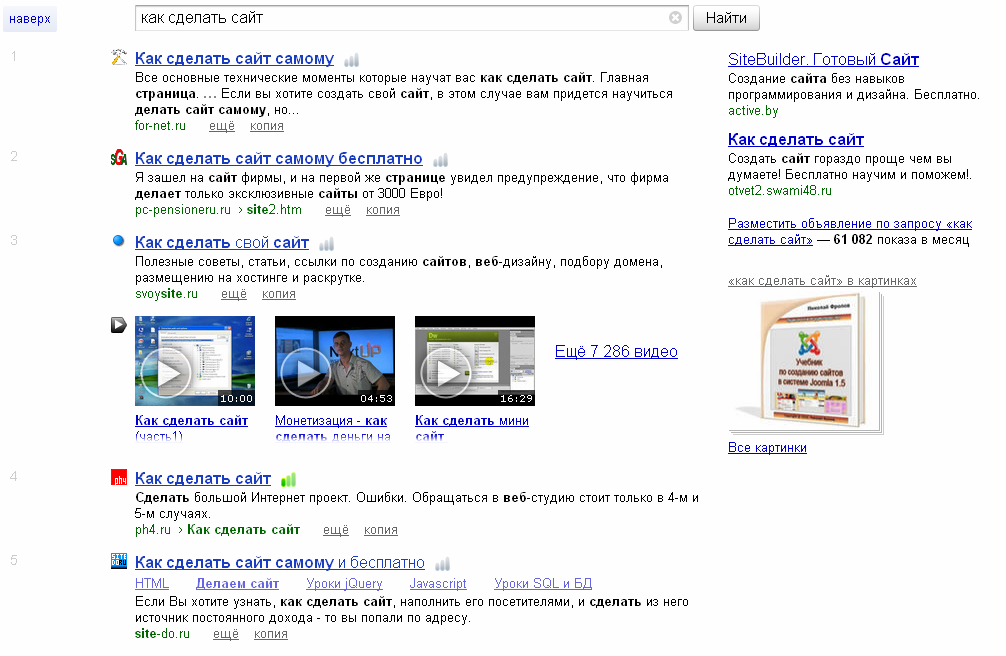

Допустим, Вы вошли в поисковую систему Яндекс (или Google) и ввели следующую фразу: "как сделать сайт". Появилось следующее:

Высветились название статьи, ссылка на статью и её краткое содержание. Как они здесь оказались? Прежде всего, поисковая система Яндекс проиндексировала множество различных сайтов, ссылки на статьи которых теперь мы видим на экране. Поэтому правильно составленный файл robots.txt облегчит не только индексацию сайта для поисковых систем, но и исключит связанные с этим ошибки. Зачем, к примеру, Яндексу индексировать страницу входа на сайт, куда сможет попасть только владелец сайта? Зачем индексировать дубли страниц, которые уже есть на главной странице сайта? Именно поэтому следует исключать не только все файлы, предназначенные для работы на вордпресс, но и все архивы, за все года.

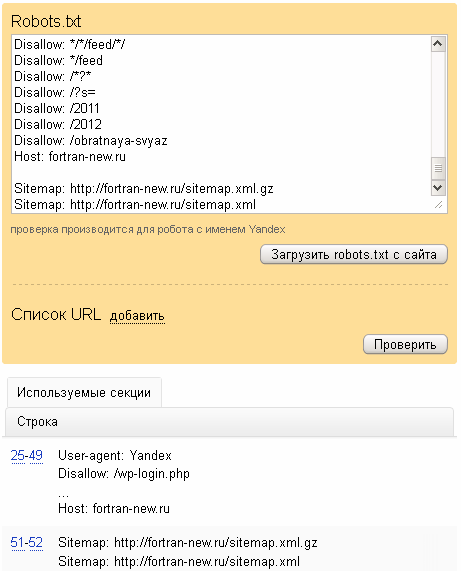

Вообще, строгих правил по составлению файла robots.txt нет. Кто-то говорит, что для Яндекса нужно отдельно прописывать директивы, кто-то считытает совсем обратное. Лично у меня с этим проблем ещё не возникало. Я сразу составил рабочий файл, загрузил его в корневую директорию сайта и проверил все запреты от индексации страниц, чтобы не возникло проблем в будущем. Высветилось следующее окно:

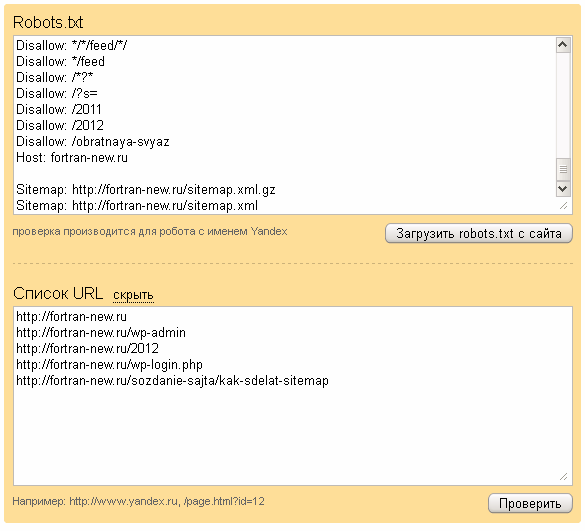

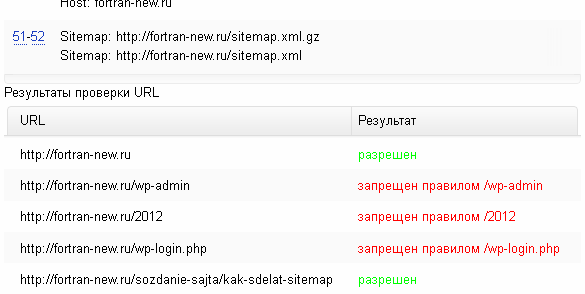

В используемых секциях видно, что Яндекс выбрал строки из файла robots.txt 25-49 и 51-52, благодаря которым учитывает, какие страницы сайта индексировать, а какие нет. Это можно даже проверить. Откроем "Список URL" и введём какие-нибудь страницы, например: https://fortran-new.ru, https://fortran-new.ru/wp-admin, https://fortran-new.ru/2012, https://fortran-new.ru/wp-login.php, https://fortran-new.ru/sozdanie-sajta/kak-sdelat-sitemap, следующим образом:

И нажимаем на кнопку "Проверить".

Как видим, все ненужные нам страницы запрещены от индексации.

И напоследок, хотелось бы дать не просто готовый файл robots.txt, но и объяснить, что ещё нужно будет прописывать туда ежегодно и каким образом это сделать.

Как упоминалось выше, бывают ситуации, когда появляется множество дублей страниц. На WordPress они есть. Например, архивы за год. Запрет в файле robots.txt прописывается директивой Disallow, после чего указывается адрес страницы. Таким образом, чтобы запретить все дубли страниц 2012 года, пропишем Disallow: /2012

И, конечно же, предлагаем воспользоваться формой, для создания robots.txt:

| http:// |

| http:// |

| http:// |

| http:// |

| http:// |

Ваш файл robots.txt:

Создайте на рабочем столе файл robots.txt, аккуратно (полностью) скопируйте в него данный код, загрузите файл в корневую директорию Вашего сайта.

Опубликовано: 2012-06-18 00:50:44